Brightadvisor.co.id – Artificial Intelligence (AI) adalah salah satu teknologi baru yang mencoba mensimulasikan penalaran manusia dalam sistem AI. Para peneliti telah membuat langkah signifikan dalam sistem AI yang lemah, sementara mereka hanya membuat tanda marjinal dalam sistem AI yang kuat.

Sebagian besar dari kita telah menggunakan Siri, Asisten Google, Cortana, atau bahkan Bixby di beberapa titik dalam hidup kita. Apakah mereka? Mereka adalah asisten pribadi digital kita.

Mereka membantu kita menemukan informasi yang berguna saat kita memintanya menggunakan suara kita. kita bisa berkata, ‘Hai Siri, tunjukkan restoran cepat saji terdekat’ atau ‘Siapa Presiden Pertama Indonesia?’.

Dan asisten akan merespons dengan informasi yang relevan dengan menelusuri ponsel kamu atau mencarinya di Web. Ini adalah contoh sederhana dari Artificial Intelligence! Mari baca lebih lanjut tentang itu!

Apa itu Artificial Intelligence (AI)?

Artificial Intelligence (AI) / Kecerdasan Buatan adalah kemampuan program komputer untuk belajar dan berpikir. John McCarthy menciptakan istilah ‘Artificial Intelligence (AI)’ pada 1950-an.

Dia berkata, ‘Setiap aspek pembelajaran atau fitur kecerdasan lainnya pada prinsipnya bisa dijelaskan dengan sangat tepat sehingga sebuah mesin bisa dibuat untuk mensimulasikannya.

Sebuah upaya akan dilakukan untuk menemukan bagaimana membuat mesin menggunakan bahasa, membentuk abstraksi, dan konsep, memecahkan berbagai masalah yang sekarang diperuntukkan bagi manusia, dan meningkatkan diri mereka sendiri.’

Contoh Artificial Intelligence (AI)

AI digunakan dalam berbagai jenis teknologi saat ini. Sebagai contoh,

- Machine Learning – Ini membantu komputer bertindak tanpa perlu pemrograman. Ada tiga jenis pembelajaran mesin:

- Pembelajaran yang diawasi – Pola bisa dikenali menggunakan kumpulan data berlabel dan kemudian digunakan untuk memberi label kumpulan data baru.

- Pembelajaran tanpa pengawasan – Kumpulan data bisa diurutkan berdasarkan seberapa mirip atau berbedanya mereka.

- Pembelajaran penguatan – Sistem AI diberikan umpan balik setelah tindakan dilakukan.

- Otomasi – Tugas bisa ditingkatkan saat alat otomatisasi digabungkan dengan AI. Pekerjaan perusahaan besar bisa diotomatisasi sementara kecerdasan dari AI diteruskan untuk memproses perubahan.

- Vision Machine – Mesin Vision menggunakan kamera, pemrosesan sinyal digital, dan konversi analog-ke-analog, untuk menangkap dan kemudian menganalisis informasi visual. Ini digunakan dalam analisis tanda tangan untuk analisis medis.

- Mobil Self-driving – Kendaraan otomatis menggunakan pembelajaran mendalam, pengenalan gambar, dan visi mesin untuk memastikan kendaraan tetap berada di jalur yang benar serta menghindari pejalan kaki.

- Robotika – Robotika adalah bidang teknik yang berfokus pada perancangan dan pembuatan robot. Saat ini, Machine Learning digunakan untuk membuat robot agar bisa berinteraksi dengan masyarakat.

Jenis Artificial Intelligence

Ada empat jenis AI:

| Mesin Reaktif | Memori Terbatas | Teori pikiran | Kesadaran Diri |

| Tugas klasifikasi dan pengenalan pola sederhana | Tugas klasifikasi yang kompleks | Memahami alasan dan motif manusia | Kecerdasan tingkat manusia yang bisa melewati kecerdasan manusia juga |

| Hebat bila semua parameter diketahui | Menggunakan data historis untuk membuat prediksi | Membutuhkan lebih sedikit contoh untuk dipelajari karena memahami motif | Rasa kesadaran diri |

| Tidak bisa menangani informasi yang tidak sempurna | Kondisi AI saat ini | Tonggak sejarah berikutnya untuk evolusi AI | Belum ada |

Sejarah Artificial Intelligence (AI)

Seperti disebutkan di atas, istilah ‘Artificial Intelligence (AI)’ diciptakan oleh John McCarthy pada tahun 1956 di Dartmouth College pada konferensi AI yang pertama. Belakangan tahun itu, JC Shaw, Herbert Simon, dan Allen Newell menciptakan program perangkat lunak AI pertama bernama ‘Logic Theorist.’

Padahal, gagasan tentang ‘mesin yang berpikir’ sudah ada sejak peradaban Maya. Di era modern, ada beberapa peristiwa penting sejak kemunculan komputer elektronik yang berperan penting dalam evolusi AI:

- Pematangan Artificial Intelligence (1943 – 1952): Walter Pitts dan Warren S McCulloch, dua matematikawan, menerbitkan ‘A Logical Calculus of the Ideas Immanent in Nervous Activity’ dalam Journal of Mathematical Biophysics. Mereka menggambarkan perilaku neuron manusia dengan bantuan fungsi logika sederhana yang mengilhami matematikawan Inggris Alan Turing untuk menerbitkan ‘Mesin Komputasi dan Kecerdasan’ yang terdiri dari sebuah tes. Tes Turing ini digunakan untuk memeriksa kemampuan mesin untuk menunjukkan perilaku cerdas.

- Kelahiran Artificial Intelligence (1952–1956): Ahli Teori Logika, program AI pertama dibuat pada tahun 1955 oleh Allen Newell dan Herbert A Simon. Itu membuktikan sekitar 52 teorema matematika dan meningkatkan bukti teorema lainnya. Profesor John McCarthy menciptakan istilah ‘Artificial Intelligence’ pada konferensi Dartmouth, dan itu diterima sebagai bidang akademik.

- Tahun-tahun emas – antusiasme awal (1956–1974): Setelah ditemukannya bahasa tingkat tinggi seperti LISP, COBOL, dan FORTRAN, para peneliti menjadi lebih bersemangat tentang AI dan mengembangkan algoritme untuk memecahkan masalah matematika yang kompleks. Joseph Weizenbaum, seorang ilmuwan komputer, menciptakan chatbot pertama bernama ‘ELIZA’ pada tahun 1966. Setahun kemudian, Frank Rosenblatt membuat komputer bernama ‘Mark 1 Perceptron.’ Komputer ini didasarkan pada jaringan saraf biologis (BNN) dan dipelajari melalui metode trial and error yang kemudian dicetuskan sebagai pembelajaran yang diperkuat. Pada tahun 1972, Jepang membangun robot humanoid cerdas pertama bernama ‘WABOT-1.’ Sejak saat itu, robot terus dikembangkan dan dilatih untuk melakukan tugas-tugas kompleks di berbagai industri.

- Ledakan AI (1980–1987): Musim dingin AI pertama (1974–1980) telah berakhir, dan pemerintah mulai melihat potensi seberapa berguna sistem AI bagi ekonomi dan kekuatan pertahanan. Sistem pakar dan perangkat lunak diprogram untuk mensimulasikan kemampuan pengambilan keputusan otak manusia dalam mesin. Al algoritma seperti backpropagation, yang menggunakan jaringan saraf untuk memahami masalah dan menemukan solusi terbaik, digunakan.

- Musim Dingin AI (1987–1993): Pada akhir tahun 1988, IBM berhasil menerjemahkan serangkaian kalimat dwibahasa dari bahasa Inggris ke bahasa Prancis. Lebih banyak kemajuan terjadi di bidang AI dan Pembelajaran Mesin, dan pada tahun 1989, Yann LeCun berhasil menerapkan algoritme backpropagation untuk mengenali kode ZIP tulisan tangan. Sistem membutuhkan waktu tiga hari untuk memberikan hasil tetapi masih cukup cepat mengingat keterbatasan perangkat keras saat itu.

- Munculnya agen cerdas (1993–2011): Pada tahun 1997, IBM mengembangkan komputer permainan catur bernama ‘Deep Blue’ yang mengungguli juara catur dunia, Garry Kasparov, dalam pertandingan catur, sebanyak dua kali. Pada tahun 2002, Artificial Intelligence (AI) untuk pertama kalinya masuk ke rumah tangga dan membangun penyedot debu bernama ‘Roomba.’ Pada tahun 2006, perusahaan multinasional seperti Facebook, Google, dan Microsoft mulai menggunakan algoritme AI dan Analisis Data untuk memahami perilaku pelanggan dan meningkatkan sistem rekomendasi mereka.

- Pembelajaran Mendalam, Data Besar, dan Kecerdasan Umum Buatan (2011–Sekarang): Dengan sistem komputasi yang semakin canggih, kini dimungkinkan untuk memproses data dalam jumlah besar dan melatih mesin kita untuk membuat keputusan yang lebih baik. Superkomputer memanfaatkan algoritme AI dan jaringan saraf untuk memecahkan beberapa masalah paling rumit di dunia modern. Baru-baru ini, Neuralink, sebuah perusahaan milik Elon Musk, berhasil mendemonstrasikan antarmuka otak-mesin di mana seekor monyet memainkan video game bola pingpong dari pikirannya.

Menarik, bukan? Tapi, bagaimana membuat AI berpikir atau belajar sendiri? Mari kita cari tahu di bagian selanjutnya.

Bagaimana Cara Kerja Artificial Intelligence (AI)?

Komputer pintar mengikuti proses, yaitu urutan langkah-langkah untuk menjalankan tugas. Jika kita memberikan langkah-langkah komputer untuk menjalankan tugas, itu harus dengan mudah bisa menyelesaikannya.

Langkah-langkahnya tidak lain adalah algoritma. Algoritme bisa sesederhana mencetak dua angka atau sesulit memprediksi siapa yang akan memenangkan pemilu di tahun mendatang!

Jadi, bagaimana kita bisa mencapai ini?

Mari kita ambil contoh memprediksi ramalan cuaca untuk tahun 2020.

Pertama-tama, yang kita butuhkan adalah banyak data! Mari kita ambil data dari tahun 2006 hingga 2019.

Sekarang, kita akan membagi data ini menjadi rasio 80:20. 80 persen dari data akan menjadi data berlabel kita, dan 20 persen sisanya akan menjadi data pengujian kita. Jadi, kita memiliki output untuk seluruh 100 persen data yang diperoleh dari tahun 2006 hingga 2019.

Apa yang terjadi setelah kita mengumpulkan data? kita akan memasukkan data berlabel (data kereta), yakni 80 persen dari data, ke dalam mesin. Di sini, algoritme belajar dari data yang telah dimasukkan ke dalamnya.

Selanjutnya, kita perlu menguji algoritme. Di sini, kita memasukkan data uji, yaitu 20 persen sisanya dari data, ke mesin. Mesin memberi kita output. Sekarang, kita memverifikasi silang output yang diberikan oleh mesin dengan output aktual dari data dan memeriksa keakuratannya.

Saat memeriksa keakuratan jika kita tidak puas dengan modelnya, kita men-tweak algoritme untuk memberikan keluaran yang tepat atau setidaknya mendekati keluaran sebenarnya. Setelah kita puas dengan model tersebut, kita kemudian memasukkan data baru ke model tersebut sehingga bisa memprediksi ramalan cuaca untuk tahun 2020.

Dengan semakin banyak kumpulan data yang dimasukkan ke dalam sistem, keluarannya menjadi semakin tepat. Nah, kita harus mencatat bahwa tidak ada algoritme yang bisa 100 persen benar. Tidak ada mesin yang mampu mencapai efisiensi 100 persen juga.

Subbidang Utama Artificial Intelligence (AI)

Artificial Intelligence (AI) bekerja dengan sejumlah besar data yang pertama-tama digabungkan dengan pemrosesan berulang yang cepat dan algoritme cerdas yang memungkinkan sistem untuk belajar dari pola di dalam data.

Dengan cara ini, sistem akan bisa memberikan keluaran yang akurat atau mendekati akurat.

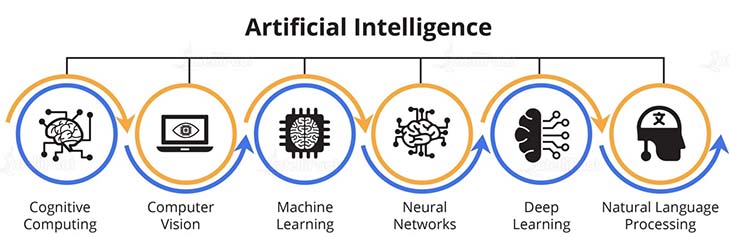

Seperti kedengarannya, Ini adalah subjek yang luas, dan ruang lingkup AI sangat luas, melibatkan proses yang jauh lebih maju dan kompleks, dan merupakan bidang studi yang mencakup banyak teori, metode, dan teknologi. Subbidang utama di bawah AI dijelaskan di bawah ini:

1. Machine Learning

Machine Learning adalah pembelajaran di mana mesin bisa belajar sendiri dari contoh dan pengalaman sebelumnya. Program yang dikembangkan untuk itu tidak perlu spesifik dan tidak statis.

Mesin cenderung mengubah atau mengoreksi algoritmenya jika diperlukan. Pembelajaran Mesin diterapkan ke hampir setiap area dan merupakan alat yang ampuh yang membuka banyak peluang.

Orang-orang dengan Sertifikasi Pembelajaran Mesin memiliki kesempatan untuk memulai karir mereka di bidang ML. Artificial Intelligence (AI) dan Machine Learning (ML) adalah dua istilah yang paling sering disalahartikan.

Umumnya, orang cenderung memahami bahwa mereka sama, yang menyebabkan kebingungan. ML adalah subbidang AI. Namun, kedua istilah tersebut diingat secara bersamaan dan berulang kali ketika topik Big Data atau Data Analytics, atau beberapa topik terkait lainnya dibicarakan.

2. Neural Networks

Artificial Neural Networks (ANNs) dikembangkan terinspirasi oleh jaringan saraf biologis, yaitu otak. JST adalah salah satu alat terpenting dalam Pembelajaran Mesin untuk menemukan pola di dalam data, yang terlalu rumit untuk dipahami oleh manusia dan diajarkan untuk dikenali oleh mesin.

3. Deep Learning

Dalam Deep Learning, sejumlah besar data dianalisis, dan di sini, algoritme akan melakukan tugas berulang kali, setiap kali memutar/mengedit sedikit untuk meningkatkan hasilnya.

4. Cognitive Computing

Tujuan akhir dari komputasi kognitif adalah meniru proses berpikir manusia dalam model komputer. Bagaimana ini bisa dicapai?

Dengan menggunakan algoritme belajar mandiri, pengenalan pola oleh jaringan saraf, dan pemrosesan bahasa alami, komputer bisa meniru cara berpikir manusia. Di sini, model terkomputerisasi digunakan untuk mensimulasikan proses kognisi manusia.

5. Computer Vision

Computer Vision bekerja dengan memungkinkan komputer untuk melihat, mengenali, dan memproses gambar, dengan cara yang sama seperti penglihatan manusia, dan kemudian memberikan hasil yang sesuai.

Vision komputer terkait erat denganAI. Di sini, komputer harus memahami apa yang dilihatnya, dan kemudian menganalisisnya.

6. Natural Language Processing

Natural Language Processing berarti mengembangkan metode yang membantu kita berkomunikasi dengan mesin menggunakan bahasa alami manusia seperti bahasa Inggris.

Sekarang kita mengerti apa itu Artificial Intelligence (AI) dan kita sudah familiar dengan subbidangnya, kita akan mempertimbangkan mengapa itu benar-benar diminati di dunia saat ini. Sebagai permulaan, inilah kutipan dari Forbes:

‘Mesin dan algoritme di tempat kerja diharapkan menciptakan 133 juta peran baru, tetapi menyebabkan 75 juta pekerjaan tergantikan pada tahun 2022 menurut laporan baru dari World Economic Forum (WEF)…

Ini berarti bahwa pertumbuhan Artificial Intelligence (AI) bisa menciptakan 58 juta pekerjaan bersih baru dalam beberapa tahun ke depan.’

Menarik, bukan? Jika kamu sedang mencari perubahan dalam pekerjaan kamu, maka Kecerdasan Buatan bisa menjadi pilihan terbaik untuk pertumbuhan karier kamu yang berkelanjutan.

Ada permintaan besar untuk para profesional Kecerdasan Buatan, saat ini.

Keuntungan Artificial Intelligence (AI)

- Mengurangi kesalahan manusia: Dengan keterlibatan manusia dalam tugas-tugas yang membutuhkan ketelitian, akan selalu ada kemungkinan kesalahan. Namun, jika diprogram dengan benar, mesin tidak membuat kesalahan dan dengan mudah melakukan tugas berulang tanpa membuat banyak kesalahan, jika tidak sama sekali.

- Penghindaran risiko: Mengganti manusia dengan robot cerdas adalah salah satu keuntungan terbesar dari Artificial Intelligence (AI). Robot AI sekarang melakukan hal-hal berisiko menggantikan manusia di tempat-tempat seperti tambang batu bara, menjelajahi bagian terdalam lautan, pengolahan limbah, dan pembangkit listrik tenaga nuklir untuk menghindari bencana.

- Mengganti pekerjaan berulang: Pekerjaan kita sehari-hari mencakup banyak tugas berulang yang harus kita lakukan setiap hari tanpa ada perubahan. Misalnya, mencuci baju atau mengepel lantai tidak mengharuskan kamu berkreasi dan mencari kemudahan baru untuk melakukannya setiap hari. Bahkan industri besar memiliki lini produksi di mana jumlah tugas yang sama harus diselesaikan dalam urutan yang tepat. Kini, mesin telah menggantikan tugas-tugas tersebut sehingga manusia bisa menghabiskan waktunya untuk melakukan hal-hal kreatif.

- Bantuan digital: Dengan asisten digital untuk berinteraksi dengan pengguna 24/7, organisasi bisa menghemat kebutuhan akan sumber daya manusia dan memberikan layanan yang lebih cepat kepada pelanggan. Ini adalah situasi yang saling menguntungkan bagi organisasi dan pelanggan. Dalam kebanyakan kasus, sangat sulit untuk menentukan apakah pelanggan sedang mengobrol dengan chatbot atau manusia.

Keterbatasan Artificial Intelligence (AI)

- Biaya pembuatan yang tinggi: Ini mungkin terdengar sedikit menyeramkan, tetapi tingkat peningkatan perangkat komputasi sangat fenomenal. Mesin perlu diperbaiki dan dirawat seiring waktu untuk memenuhi persyaratan terbaru, yang membutuhkan banyak sumber daya.

- Tanpa emosi: Tidak diragukan lagi bahwa mesin jauh lebih kuat dan lebih cepat daripada manusia. Mereka bisa melakukan banyak tugas secara bersamaan dan memberikan hasil dalam sepersekian detik. Robot bertenaga AI juga bisa mengangkat lebih banyak beban, sehingga meningkatkan siklus produksi. Namun, mesin tidak bisa membangun hubungan emosional dengan manusia lain, yang merupakan aspek krusial dalam manajemen tim.

- Pemikiran kotak: Mesin bisa dengan sempurna menjalankan tugas atau operasi yang ditugaskan sebelumnya dengan rentang batasan yang pasti. Namun, mereka mulai menghasilkan hasil yang ambigu jika mereka mendapatkan sesuatu dari tren tersebut.

- Tidak Bisa Berpikir Sendiri: Artificial Intelligence (AI) bertujuan untuk memproses data dan membuat keputusan secara sadar seperti yang kita lakukan sebagai manusia. Namun, saat ini, ia hanya bisa melakukan tugas yang diprogramkan. Sistem ini tidak bisa membuat keputusan berdasarkan emosi, kasih sayang, dan empati. Misalnya, jika mobil tanpa pengemudi tidak diprogram untuk menganggap hewan seperti rusa sebagai organisme hidup, mobil itu tidak akan berhenti meskipun menabrak rusa dan menjatuhkannya.

Kesimpulan

Ada ketakutan yang berkembang bahwa penerapan Artificial Intelligence (AI) secara luas akan mengikis pekerjaan manusia.

Bukan hanya rakyat jelata tetapi pengusaha seperti Elon Musk menyuarakan peringatan dengan meningkatnya laju penelitian yang dilakukan di domain AI.

Mereka juga berpandangan bahwa sistem AI bisa membuka jalan bagi kekerasan skala besar di dunia. Tapi itu adalah cara pandang yang sangat rabun!

Dalam beberapa dekade terakhir, teknologi telah berkembang pesat dan masif. Selama seluruh kursus, untuk setiap pekerjaan yang hilang karena teknologi, selalu ada peran pekerjaan baru dan segar yang muncul.

Jika ini adalah kasus di mana teknologi baru menggantikan semua pekerjaan manusia, maka, saat ini, sebagian besar dunia akan kehilangan pekerjaan. Bahkan Internet pada awal kemunculannya telah mengumpulkan banyak ulasan negatif.

Tapi, sekarang sudah jelas bahwa internet tidak akan pernah bisa tergantikan. kamu tidak akan membaca blog ini jika itu masalahnya.

Demikian pula, meskipun itu mengotomatiskan sebagian besar kemampuan manusia, potensi dan niat baiknya akan meningkat dan bermanfaat bagi umat manusia secara umum.

Artikel lainnya: